大家好,我是阿超!今天要给大家介绍一个让我眼前一亮的AI工具——exo。这个项目在GitHub上已经获得了超过30.5k的星星,可以说是近期最热门的AI项目之一了!

什么是exo?

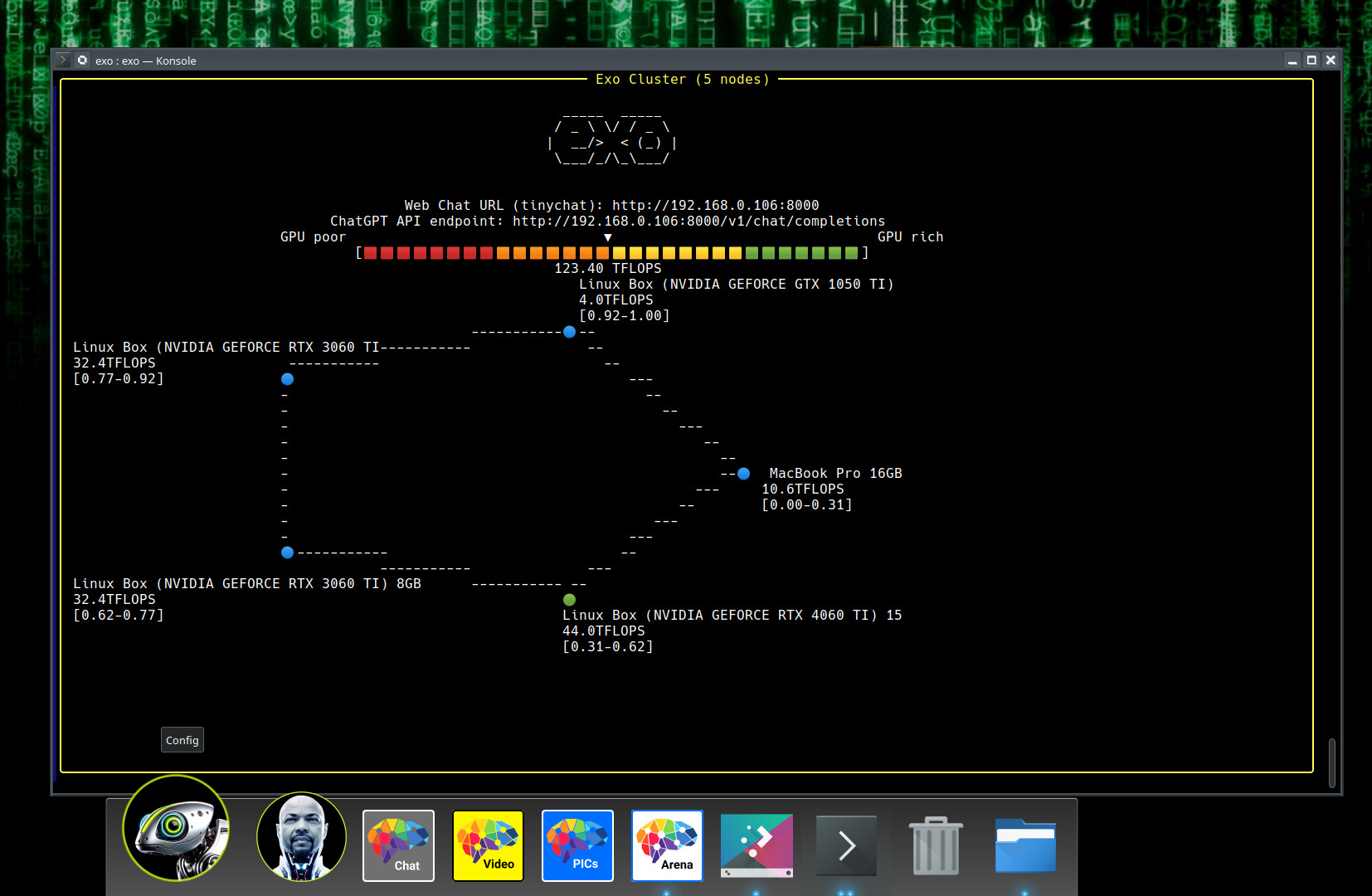

简单来说,exo是一个让你能用家里各种设备搭建AI集群的开源框架。想象一下,把你的iPhone、iPad、MacBook、Android手机、甚至树莓派都连接起来,组成一个超级强大的AI计算集群!这听起来是不是很科幻?但exo真的做到了。

核心功能亮点

🚀 设备聚合神器

exo最厉害的地方在于它能自动发现和整合各种设备。你不需要做复杂的配置,只需要在每个设备上运行exo命令,它们就会自动找到彼此,形成一个统一的AI计算资源池。

🧠 智能模型分割

exo采用动态模型分割技术,能够根据每个设备的硬件能力(内存、GPU性能等)智能地分配模型的不同层。这意味着你可以运行比任何单个设备内存都大的模型!

🔄 多种推理引擎支持

- MLX:专门为Apple Silicon优化的引擎

- tinygrad:轻量级但高效的推理引擎

- PyTorch(开发中)

- llama.cpp(开发中)

🌐 多种网络发现方式

- UDP自动发现

- 手动配置

- Tailscale网络

- 蓝牙和无线电(开发中)

安装和使用超级简单

硬件要求

说实话,exo的要求真的很亲民!只要所有设备的总内存能装下整个模型就行。比如:

- 2台8GB内存的M3 MacBook Air

- 1台16GB的NVIDIA RTX 4070 Ti笔记本

- 2台4GB树莓派 + 1台8GB Mac Mini

安装步骤

<BASH>git clone https://github.com/exo-explore/exo.gitcd exopip install -e .# 或者使用venvsource install.sh

使用方法

简单到令人发指:

<BASH># 在设备1上exo# 在设备2上 exo

就这样!两个设备会自动连接,然后你就可以在 http://localhost:52415 访问ChatGPT风格的Web界面了。

实际应用场景

🏠 家庭AI助手

把家里不用的旧手机、平板、电脑都利用起来,搭建一个私有的AI助手,既保护隐私又节省成本。

👨💻 开发者测试

想要测试大模型但硬件不够?用exo把多台设备组合起来,就能运行Llama 3.1 405B这样的超大模型!

🎓 教育学习

学生党可以用几台便宜的设备组合起来学习AI模型推理,成本大大降低。

技术优势

对等网络架构

exo不是传统的主从架构,而是真正的对等网络。每个设备都是平等的,只要连接到网络中就能参与计算。

异构设备支持

不同品牌、不同系统、不同硬件的设备都能协同工作,这种兼容性真的很强大。

ChatGPT兼容API

提供完全兼容OpenAI的API接口,你的现有应用只需要改一行代码就能切换到自己的硬件上运行。

使用体验

阿超实际测试后发现,exo的自动发现功能确实很智能,设备之间的连接几乎不需要人工干预。性能方面,虽然异构设备会有些性能损失,但能够运行超大模型这个优势已经足够吸引人了。

不过要注意的是,exo目前还是实验性软件,可能会遇到一些bug。但开发团队响应很积极,社区也很活跃。

适合人群

- AI爱好者:想要体验大模型但硬件有限的用户

- 隐私关注者:希望在自己设备上运行AI模型的用户

- 开发者:需要测试不同硬件配置下模型性能的开发者

- 教育机构:预算有限但想开展AI教学的学校

总结

exo真的是一个很有想法的项目!它打破了”必须要有昂贵硬件才能玩AI”的传统观念,让我们普通人也能用现有的设备体验大模型的魅力。虽然目前还在早期阶段,但发展潜力巨大。

如果你家里有几台闲置设备,不妨试试exo,感受一下把手机、平板、电脑变成AI超级计算机的神奇体验!

官网链接: https://github.com/exo-explore/exo

关键词: exo, AI集群, 分布式推理, 设备聚合, 模型分割, 开源AI, 家庭AI